Техническая оптимизация сайта [Самое главное]

Все работы по оптимизации сайта будут напрасны если есть технические ошибки, которые помешают:

- проиндексировать все страницы сайта;

- поисковым роботам понять структуру сайта;

- посетителям найти необходимую информацию;

- поисковому алгоритму корректно ранжировать сайты в поисковой выдаче.

В этой статье Вы узнаете какие же технические ошибки существуют и как их исправлять.

Общие технические требования ко всем сайтам

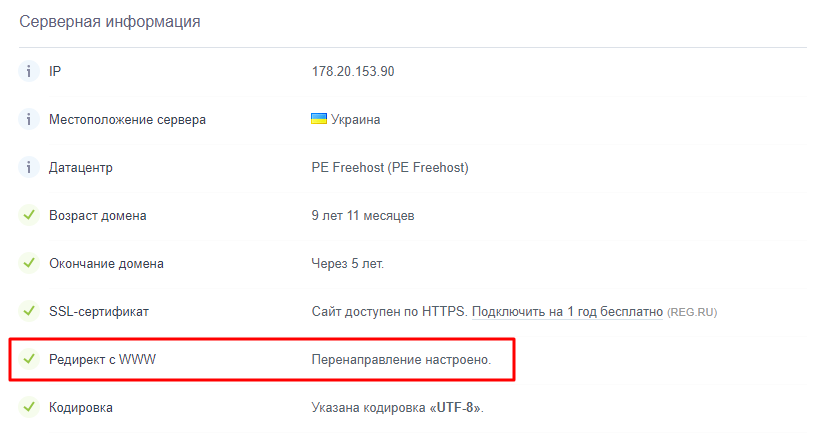

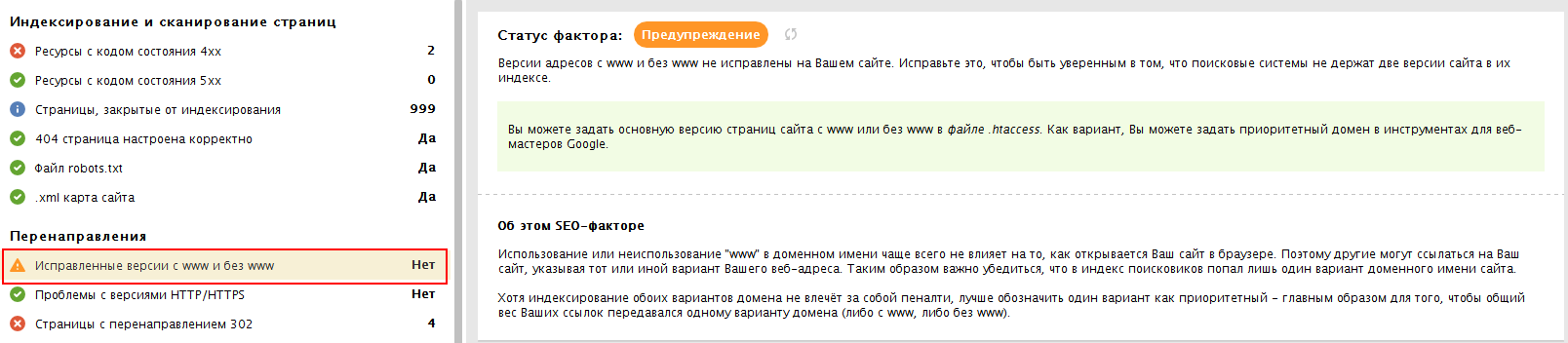

- Редирект на главное зеркало сайта (с www на без www или наоборот).

Проверить настроен ли редирект на главное зеркало сайта поможет сервис a.pr-cy.ru или программа WebSiteAuditor.

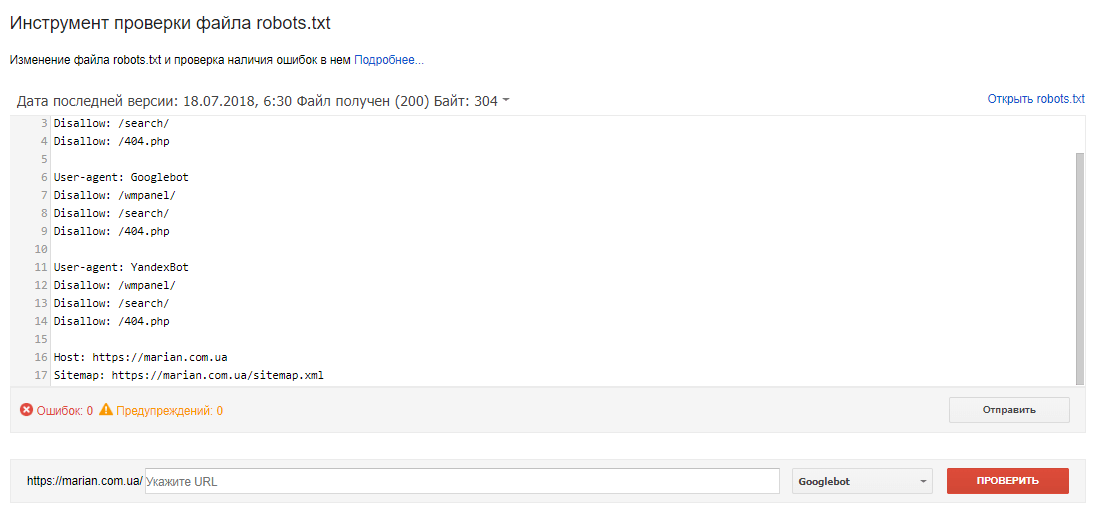

- Корректная настройка файла robots.txt

Необходимо отдельно прописать правила для Google, Яндекса и других поисковых систем.

Например, директиву Host Гугл не поддерживает, только Яндекс.

Проанализировать корректность файла robots.txt Вы можете в Google Search Console с помощью Инструмента проверки файла robots.txt:: https://www.google.com/webmasters/tools/robots-testing-tool

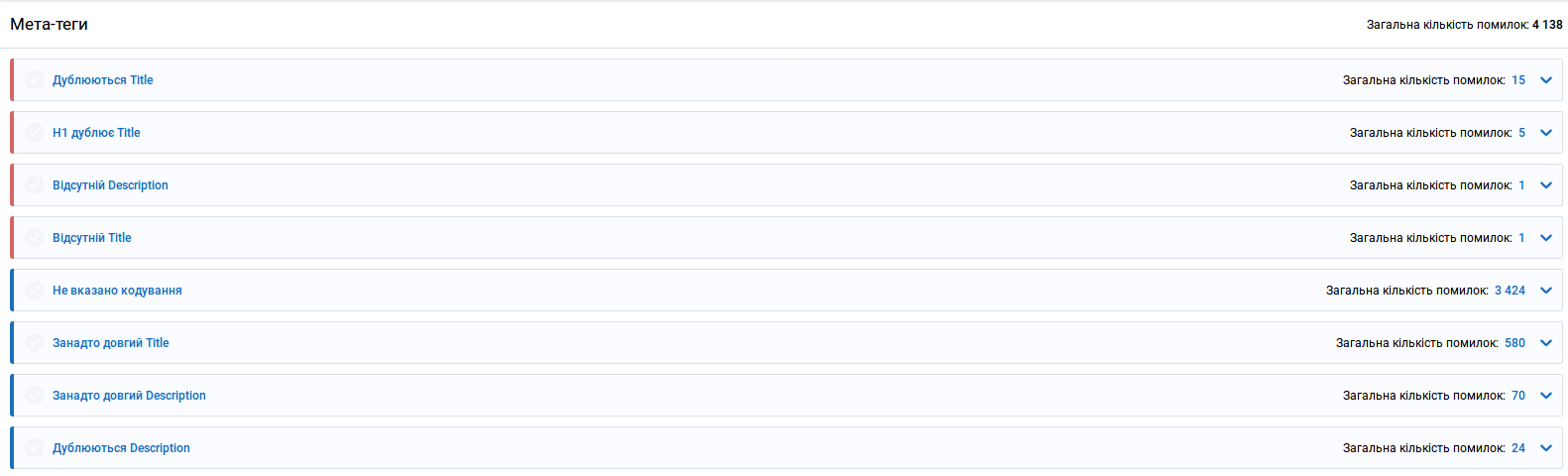

- Все страницы сайта должны имеет свой уникальный Title и Description, которые точно описывают их содержание. Это касается и страниц пагинации (2 ст, 3 ст и т. д.).

Проверить уникальность этих тегов можно с помощью специализированных сервисов или программ: Serpstat, Netpeak Spider, WebSite Auditor и др.

- ЧПУ (человекопонятные урлы) для всех продвигаемых страниц, а еще лучше для всех страниц сайта.

Например, https://site.ua/product/choboti-lemigo-vermont-877-eva-7/ а не https://site.ua/product/0789ofd

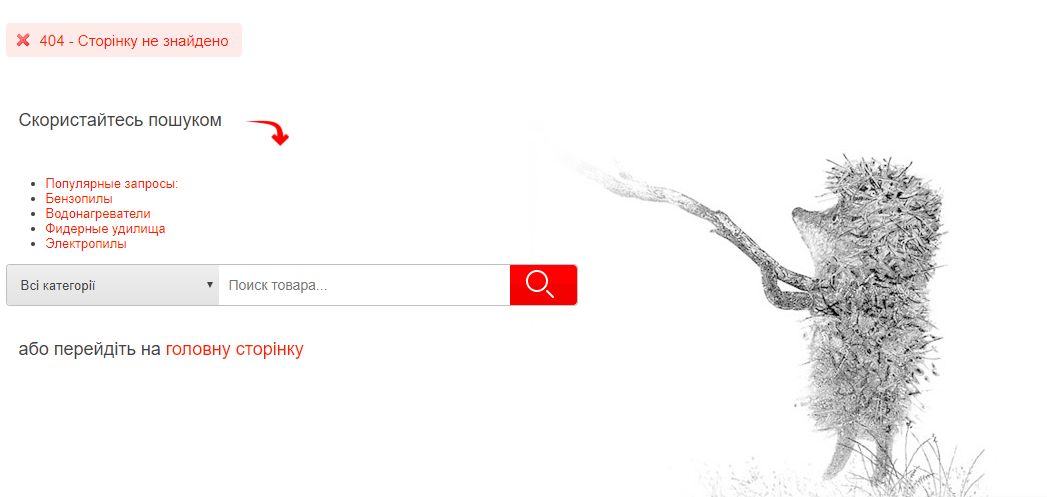

- Наличие и корректность работы страницы с ошибкой 404. Страница должна отдавать ответ с кодом «404 Not Found».

Страница с ошибкой 404 должна выводится при вводе ошибочных URL-адресов. Дизайн этой страницы должен быть в стиле сайта и содержать ссылки на основные страницы сайта, а также форму поиска.

- Все страницы, доступны по ссылкам, должны иметь код ответа «200 ОК».

Нужно просканировать сайт специальными сервисами или программами: Netpeak Spider, ScreamingFrog, WebSiteAuditor и др.

Если есть страницы с 301 редиректом — нужно скорректировать URL внутренних страниц на сайте. Они должны сразу вести на конечную цель.

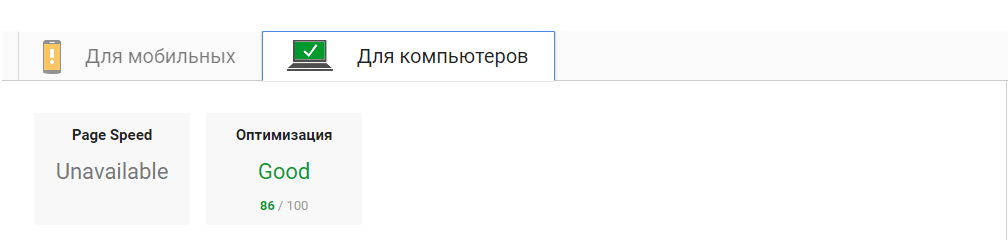

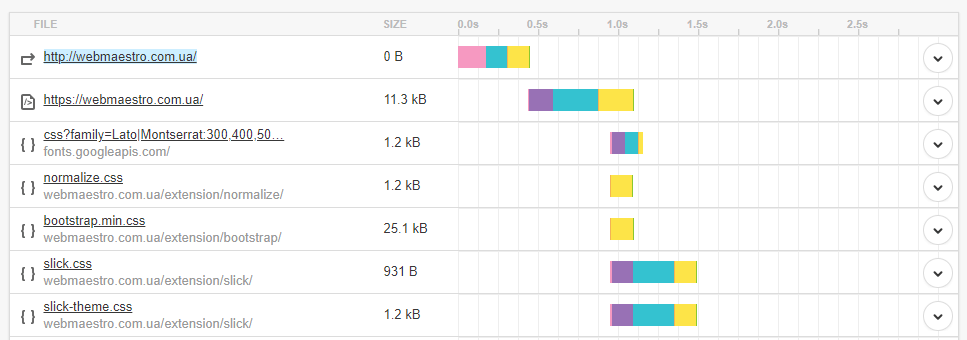

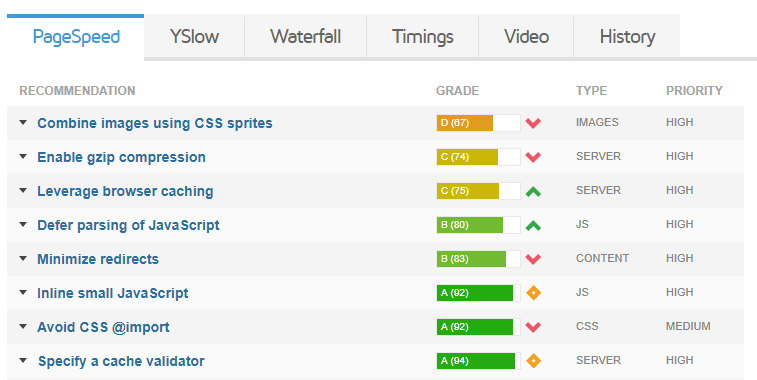

- Время загрузки страниц сайта и их размер в Кб.

Рекомендуемые показатели:

- время скачки исходного кода документа — до 0,7 с (700 мс);

- время ответа сервера — до 0,2 с (200 мс);

- размер исходного кода — до 120 Кб.

Можете воспользоваться следующими сервисами:

- Google Page Speed Insights https://developers.google.com/speed/pagespeed/insights:

- Pingdom Tools https://tools.pingdom.com/

- Gtmetrix https://gtmetrix.com/

- PR-CY https://pr-cy.ru/speed_test/

- На всех страницах обязательно должен быть заголовок в теге Н1 и он должен быть только один.

Заголовок в теге Н1 должен точно описывать содержимое страницы и отличатся от Title.

- Проверьте, чтобы теги Н1..Н6 использовались по назначению, а не как элементы оформления сайта.

Неправильно:

<Н1>Наш номер телефона: 066-123-45-67Правильно:

<Н1>Разробка сайтов - Аптайм сервера должен иметь показатель 99,85% и выше.

Для проверки можете воспользоваться онлайн-сервисом https://www.host-tracker.com.

- Привлекательный и оригинальный favicon.ico, который должен находиться в корне сайта.

- С помощью AJAX скрыть ссылки на страницах, закрытых от индексации в robots.txt, чтобы статический вес внутри сайта распределялся правильно. В исходном коде страниц сайта не должно быть конструкции типа «a href=”...”» с ссылками на такие страницы.

Скрипт также нужно будет закрыть от индексации.

- Большие фрагменты JS и CSS (8-10 строк и более) вынести в отдельные файлы определенного типа, которые подключаются отдельно. Все временные комментарии (более 3-5 строк) удалить. Это ускорит скачку и интерпретацию кода поисковыми системами и браузерами.

- Проверьте валидность кода на наличие незакрытых парных тегов.

Это можно сделать с помощью онлайн-валидатора W3C Markup Validator Service https://validator.w3.org.

- Проверьте корректность отображения сайта в самых популярных браузерах (кроссбраузерность): Google Chrome, Opera, Mozilla Firefox, Android Browser, Safari Mobile.

- Все URL страниц сайта должны иметь одинаковую конструкцию (или со слешем вконце «/» или без него, или с суффиксом .php, .html).

Например, site.ua/development/

site.ua/development

site.ua/development.php

- Правильно настройте 301-редирект с версии сайта http на версию https для избежания дублированности контента.

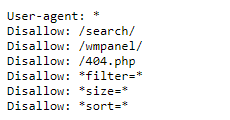

- Закройте от индексации в файле robots.txt страницы поиска, фильтрации, сортировки (если они не оптимизированы для продвижения по НЧ-запросам), страницу с ошибкой 404, страницы входа в админ-панель, страницы авторизации, смены пароля, оформления заказа, версии для печати, страницы совершения действия, разделы с дублированным контентом (например, RSS-фиды) с помощью директивы Disallow:

Также скрываем от индексации файлы с расширением *.doc, *.pdf, если они не несут полезной информации. - Как альтернативу файлу robots.txt можно использовать тег name=”robots” со значением «content ="noindex, follow"».

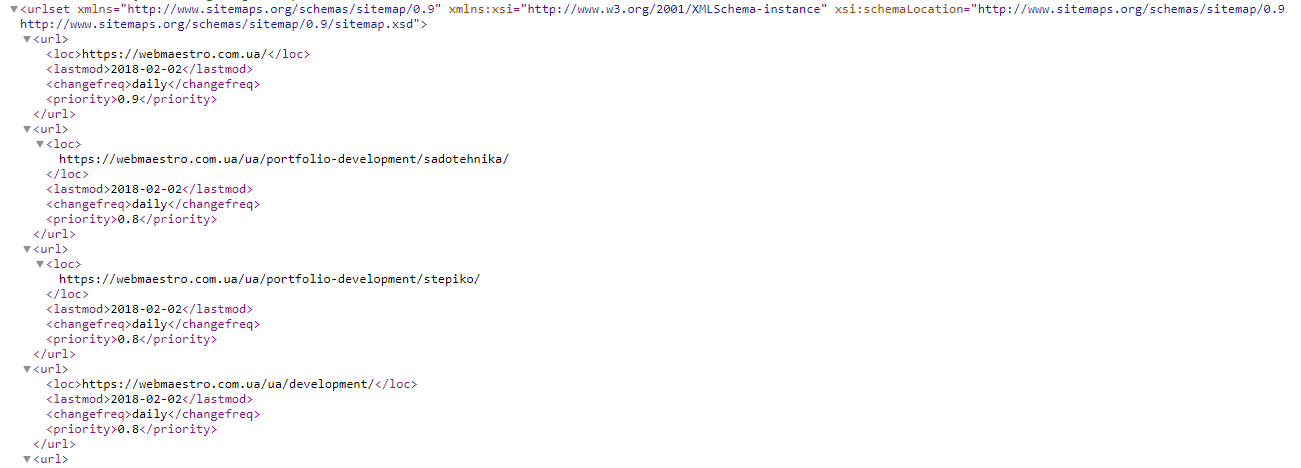

- Сформируйте карту сайта sitemap.xml, где перечислите все страницы сайта.

Затем проверьте карту сайта на валидность с помощью опции Проверка файла Sitemap в Google Search Console https://www.google.com/webmasters/tools/sitemap-list.

Если число страниц сайта превышает 50 тыс., нужно создать несколько карт. - Если на сайте есть ссылки на сторонние сайты, прописываем им открытие в новой вкладке с помощью target=”_blank” и скрываем их от поисковых систем с помощью AJAX.

- Настройте rel=”canonical” чтобы исключить дубли страниц.

Правильно настроенный атрибут rel=”canonical” для тега link:

- упростит настройку индексации сайта;

- поможет правильно учитывать и склеивать статистику на дублирующих страницах

- Даже если Вы правильно и подробно настроили индексацию, необходимо постоянно просматривать попадания дублей контента в индекс ПС. Это делается с помощью операторов цитатного поиска и оператора «site:».

Заключение

Такие ошибки, как дубли страниц в поиске или выпадение важных страниц с поиска, могут помешать на пути к ТОПу поисковой выдачи.

В этой статье мы описали самые полезные работы по технической оптимизации сайта. Вы можете их использовать как чек-лист в своей работе.

Помните, корректная техническая оптимизация сайта — фундамент раскрутки!

Вы можете обратиться к нам и все эти работы мы проведем на Вашем сайте сами. Обращайтесь!

![SEO БОМБА от WEBMAESTRO [Мультиканальная раскрутка], блог, фото](/img/blog/20180324192737_.jpg)

Бажаєте встановити наш додаток?

Бажаєте встановити наш додаток?

ответить

ответить

ответить

ответить

ответить