Эволюция алгоритмов ранжирования Google

В этой статье мы расскажем о том:

- каким поисковик Google был раньше;

- какие методы фильтрации результатов выдачи он использовал;

- когда и какие обновления внедрял;

- как сегодня он ранжирует сайты.

С чего все начиналось?

Первое что упростил Интернет ― это общение между людьми и компаниями благодаря электронной почте. Потом появилась необходимость сделать информацию общедоступной.

Упрощение процесса поиска и его общедоступность стали основной концепцией работы Google, Yahoo и др. Когда Интернет дошел до России, в конкуренцию включились Rambler, Яндекс, LiveInternet.

Периоды развития Google

- Недостаточное количество контента

Когда контента в Интернете было мало, владельцы сайтов думали только об одном –

чтобы их сайт нашли.

В тот период ни один поисковик не мог обеспечить наиболее точное соответствие запросу на первой странице выдачи, и пользователи просматривали все результаты выдачи. А все потому, что:

- Информации было слишком мало.

- Контент вообще не был оптимизированным.

- Алгоритмы ранжирования были слишком примитивными.

Например, чтобы сайт показывался в поисковой выдаче достаточно было прописать мета-теги на странице:

- заголовок (Title) ― чтобы сайт выдавался по определенному запросу, достаточно было прописать его в заголовке страницы и в мета-теге Keywords;

- краткое описание (Description) ― если поисковик не находил запрос в ключевых словах и заголовках, он искал в описании;

- ключевые слова (Keywords) ― прописывали много ключевиков, чтобы поисковик нашел страницу сайта.

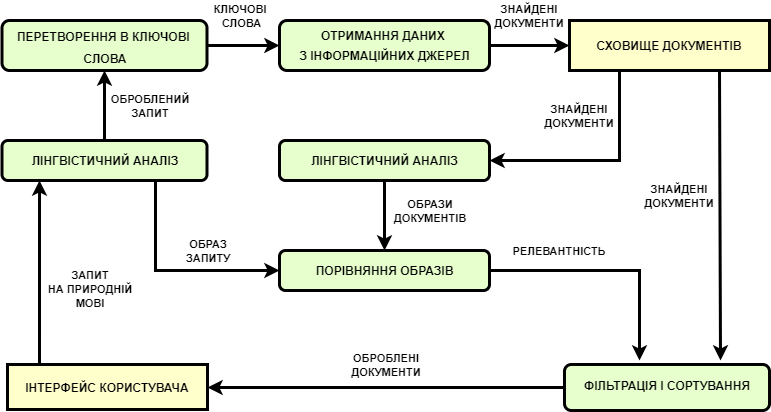

Поисковые системы работали по следующему алгоритму:

Тогда главной целью Google было найти что-нибудь максимально похожее на запрос пользователя.

В то время все поисковики конкурировали между собой, и тот, который умел находить более релевантные результаты – занимал место монополиста. Например, первые поисковые системы появились в 1993-1995 годах (Aliweb, Lycos, WebCrawler и др.), Google был создан в 1998 году, Яндекс ― в 1997, Rambler ― 1996, Yahoo ― 2004, Bing ― 2004-2005 гг.

- Рост количества контента

Когда стало появляться больше контента в сети, в поисковой выдаче стало мало места и все хотели попасть на первую страницу выдачи. В тот период в лидеры выбились 2 поисковика: Google и Яндекс. Все начали осваивать простейшие алгоритмы ранжирования. Именно тогда и возникла специальность SEO-оптимизатор.

Все сайты стали оптимизировать по нескольким принципам:

- Максимальный переспам ключевиками в контенте и мета-тегах.

- Наращивание массы спамных ссылок, «надувание» SEO-показателей сайта (траста, трафика, PageRank, ТИЦ и др.).

Тогда и зародилось «черное» SEO ― создавалось много спамных страниц под определенные ключевые запросы, которые редиректили на другие страницы. Поисковая выдача сильно испортилась. Сейчас использование такой схемы чревато попаданию под санкции и исчезновению из поисковой выдачи.

- Появление апдейтов (обновлений)

В этот период возрос риск «подцепить» вирус из поиска или попасть на спамный сайт, дорвей или фишинг-сайт. Он начался в 2005 году и длится по сегодня. В этом периоде можно выделить 2 этапа:

- Становление алгоритмов ранжирования (2005-2011 гг.). На этом этапе создавались первые алгоритмы фильтрации поисковой выдачи и именно тогда зародились черные методы SEO.

- Значимые апдейты поисковых систем направленные на борьбу с нечестными методами оптимизации сайтов (2012-2017 гг.).

Второй этап развития поисковых систем является природным процессом эволюции: атака («черных» оптимизаторов) и защита (поисковых систем).

Именно в этот период самые выдающиеся поисковые системы, такие как Яндекс и Google, начали усердно бороться за каждого пользователя и внедрять первые алгоритмы ранжирования. Черным SEO-шникам пришлось уходить из профессии или прибегать к иным способам раскрутки сайтов.

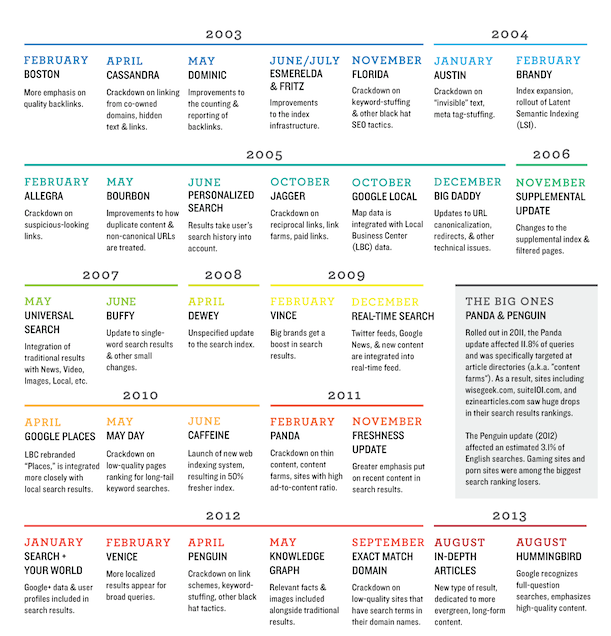

Самые важные апдейты Google

- Boston (февраль 2003 год) ― первый официальный апдейт Google. Использовались разные способы изменения алгоритмов, четкой направленности не было.

- Cassandra (апрель 2003) ― поисковик отсеивал сайты со скрытыми ссылками и текстами, ссылками с сайтов-дорвеев, которые принадлежали одному владельцу.

- Dominic (май 2003) ― Google стал по-другому учитывать обратные ссылки, появились боты Deepcrawler и Freshbot.

- Esmeralda (июнь 2003) ― последний этап апдейта Boston.

- Fritz (июль 2003) ― после него обновления стали происходить каждый день, а не месяц.

- Florida (ноябрь 2003) ― удаляет из выдачи сайты перенасыщенные ключевыми словами, неуникальным контентом, покупными ссылками.

- Brandy (февраль 2004) ― Google начинает понимать LSI-запросы, анкоры ссылок.

- Nofollow (январь 2005) ― Google внедряет параметр nofollow для борьбы со спамными ссылками.

- Bourbon (май 2005) ― выделил сайты с www и без www как дублированный контент.

- Персонализированный поиск (июнь 2005) ― Google начал использовать файлы cookies для формирования поисковой выдачи согласно персональным предпочтениям.

- XML-карта сайта (июнь 2005) ― Google ввел понятие карты сайта sitemap.xml и стал использовать ее для улучшения индексации.

- Jagger (октябрь 2005) ― фильтровал сайты созданные для покупки и обмена ссылками.

- Big Daddy (декабрь 2005) ― ввелись новые понятия: канонизация, редиректы и др.

- Универсальный поиск (май 2007) ― в выдаче появились картинки, новости, видео, локальные сайты.

- Suggest (2008) ― появились поисковые подсказки.

- Rel-canonical (февраль 2009) ― Google и другие поисковики разрешили веб-мастерам настраивать канонические страницы.

- Caffeine (август 2009) ― начались вводиться новинки: выдача в реальном времени, скорость сканирования и индексации, расширенный индекс. Большое значение стало придаваться контенту, частоте обновления сайта, внутренней оптимизации, скорости загрузки страниц. Внедряются санкции за спамность и технические проблемы на сайте.

- Поиск в реальном времени (декабрь 2009) ― возрастает скорость индексации страниц.

- May Day (май 2010) ― стали учитываться низкочастотные запросы с длинным «хвостом».

- Мгновенный поиск (сентябрь 2010) ― результаты выдачи стали предоставляться в момент набора запроса пользователем.

- Негативные отзывы (декабрь 2010) ― поисковик начал учитывать при ранжировании сайтов отзывы пользователей.

Потом обновления участились.

Самые известные апдейты Google

- Panda (февраль 2011) ― апдейт понизил позиции сайтов со слабым контентом и «фермы» контента переспамленные низкочастотными запросами. Алгоритм совершенствовался до 2015 года.

- PayDay Loan (2013-2014) ― отсеивал спамные финансовые и порно-сайты.

- Penguin (апрель 2012) ― анализировал количество и качество внешних ссылок на сайт и фильтровал спам, а также мониторил внешние и внутренние факторы. Тогда и был внедрен инструмент Disavow Links для отклонения сомнительных внешних ссылок.

- Pigeon (июль 2014) ― корректирование локального поиска, для некоторых запросов принималось во внимание расстояние от пользователя до адреса компании.

- Pirate (август 2012) ― введены правила DMCA для борьбы с пиратским контентом, который исключался из поисковой выдачи.

- EMD (сентябрь 2012) ― название домена перестало учитываться при ранжировании.

- Top heavy (январь 2012) ― из выдачи исключены сайты переспамленные рекламой (баннерами и видео).

- Hummingbird (август 2013) ― введена кластеризация ключевых слов по темам, что дало возможность Google выдавать более релевантные результаты.

- Mobile Friendly (2015) ― в поисковой выдачи отдавалось предпочтение сайтам с мобильной адаптацией.

Таким образом, мы видим, что Google эволюционировал в сторону упрощения процесса поиска и максимального удовлетворения потребностей пользователей.

Как Google ранжирует сайты?

Поисковые системы работают по схеме: обработать введенный пользователем поисковый запрос и представить правильные ответы.

Все поисковые системы основываются на 3 правилах:

- Актуальность

Информация на сайте всегда должна быть актуальной. Например: цены товаров, их описание, фотографии, наличие на складе, актуальная информация в блоге.

- Полнота

Подробная информация о товарах/услугах. Разделение контента по страницам, его структурирование.

- Известность

Продвигайте контент, ссылайтесь на него с других источников: соц сетей, новостных порталов, СМИ и т. д.

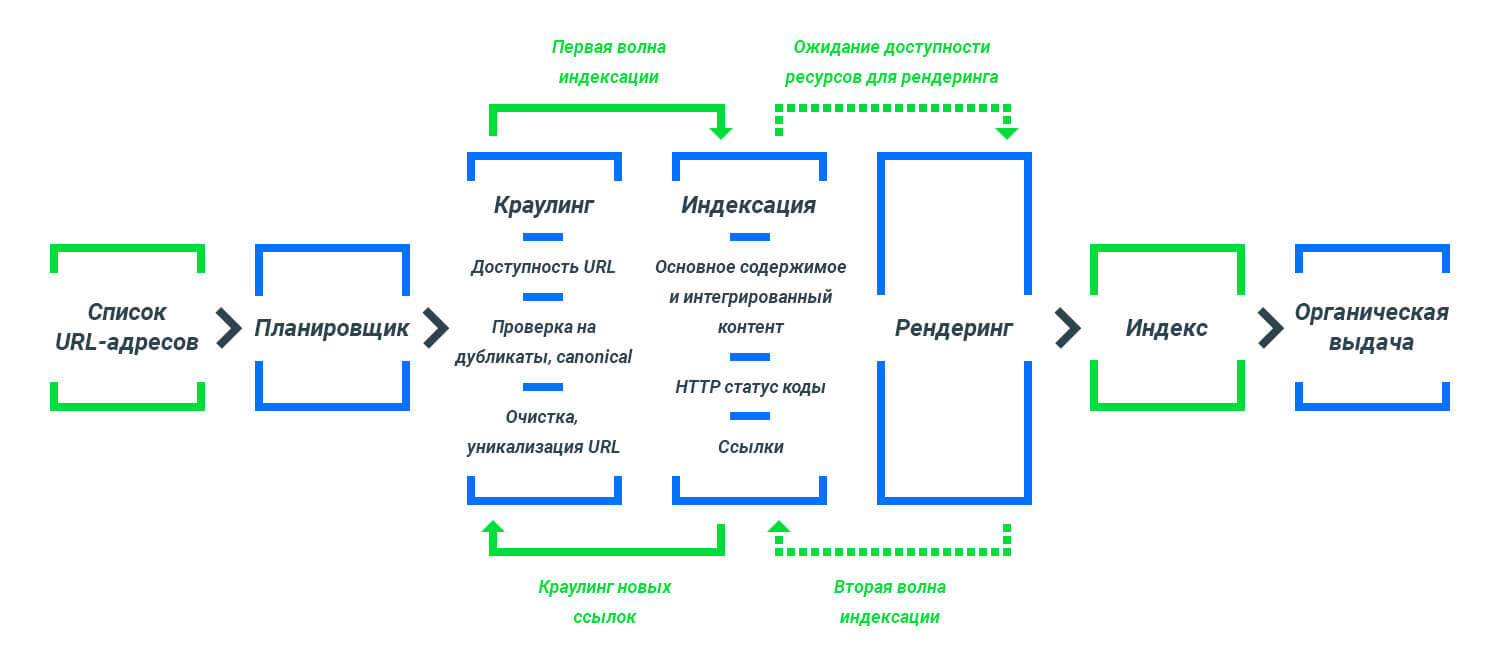

Процесс попадания страниц сайтов в поисковую выдачу Google

Факторы ранжирования в Google 2019

Google имеет множество факторов ранжирования. Наиболее приоритетные из них:

- Количество прямых переходов на сайт.

- Время, которое пользователи проводят на сайте, количество просмотренных страниц, процент отказов.

- Количество ссылающихся доменов.

- Длина контента.

- Наличие протокола безопасности HTTPS.

- Количество анкоров, ключевые слова в анкорах.

- Наличие ключевых запросов на странице.

- Плотность ключевых запросов.

- Наличие ключевиков в заголовках (H1, H2...).

- Наличие ключевиков в мета-тегах (Title, Description).

- Наличие видео на странице.

- Возраст домена.

- Техническая составляющая сайта (минимум редиректов, правильная настройка страницы 404, высокая скорость загрузки сайта, наличие мобильной адаптации, микроразметки и т. д.).

Теперь Вы знаете приоритеты поисковой системы Google.

Заключение

Итак, мы видим, что на сегодняшнее время Google достиг внушающего уровня развития и научился точно понимать запросы пользователей, а при ранжировании выдает максимально релевантные результаты.

За качественной раскруткой сайта обращайтесь к нам ― мы разработаем стратегию развития Вашего сайта согласно рекомендациям Google!

Бажаєте встановити наш додаток?

Бажаєте встановити наш додаток?