Технічна оптимізація сайту [Найголовніше]

Всі роботи по оптимізації сайту будуть марні якщо є технічні помилки, які перешкодять:

- проіндексувати всі сторінки сайту;

- пошуковим роботам зрозуміти структуру сайту;

- відвідувачам знайти необхідну інформацію;

- пошуковому алгоритму коректно ранжувати сайти в пошуковій видачі.

У цій статті Ви дізнаєтесь які ж технічні помилки існують, і як їх виправляти.

Загальні технічні вимоги до всіх сайтів

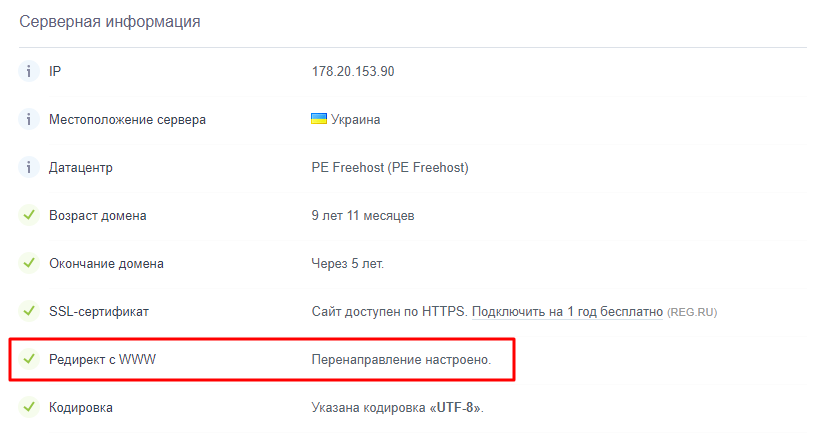

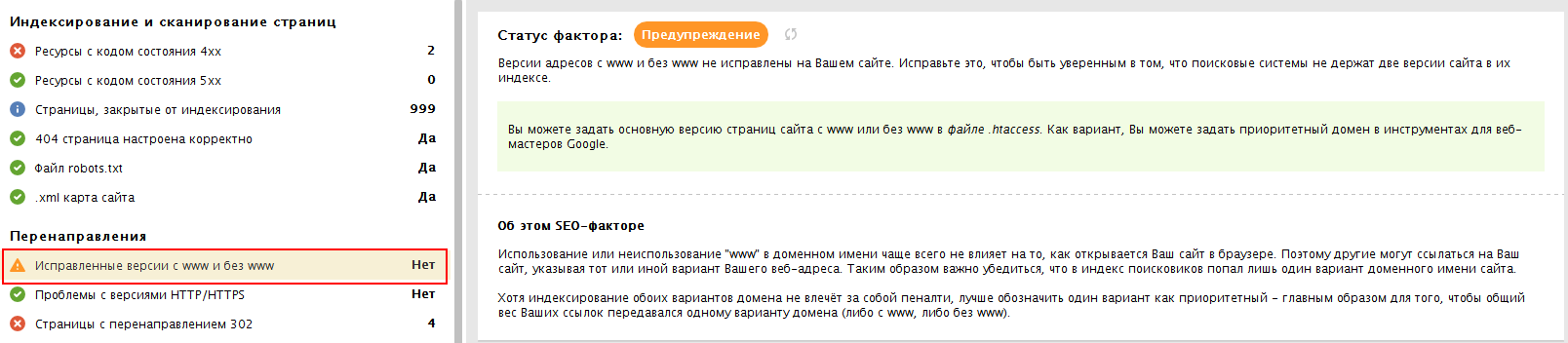

- Редірект на головне дзеркало сайту (з www на без www або навпаки).

Перевірити чи налаштований редірект на головне дзеркало сайту допоможе сервіс a.pr-cy.ru або програма WebSiteAuditor.

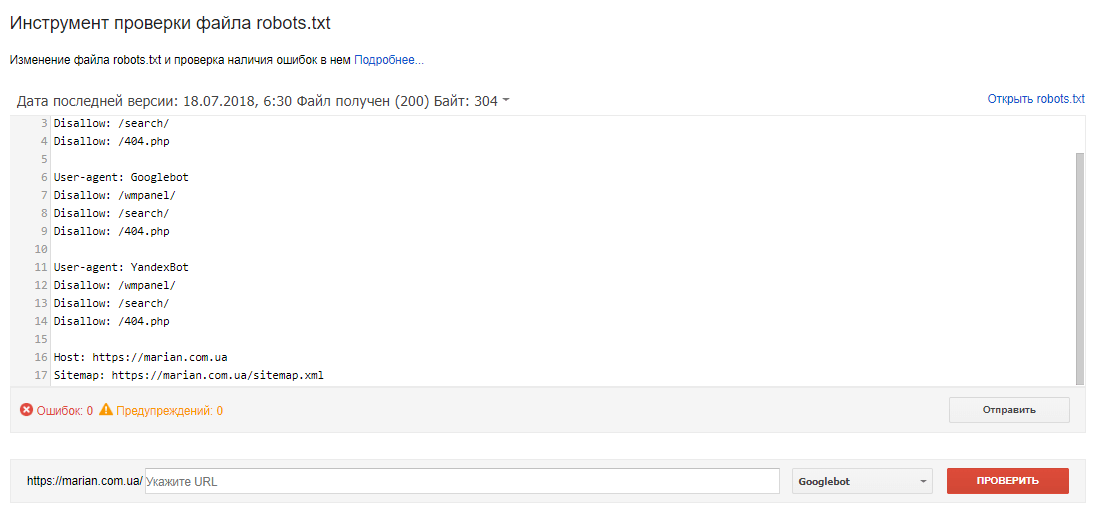

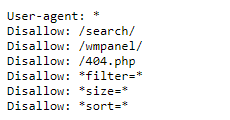

- Коректна настройка файлу robots.txt

Необхідно окремо прописати правила для Google, Яндексу та інших пошукових систем.

Наприклад, директиву Host Гугл не підтримує, тільки Яндекс.

Проаналізувати коректність файлу robots.txt Ви можете в Google Search Console за допомогою Інструменту перевірки файлу robots.txt: https://www.google.com/webmasters/tools/robots-testing-tool

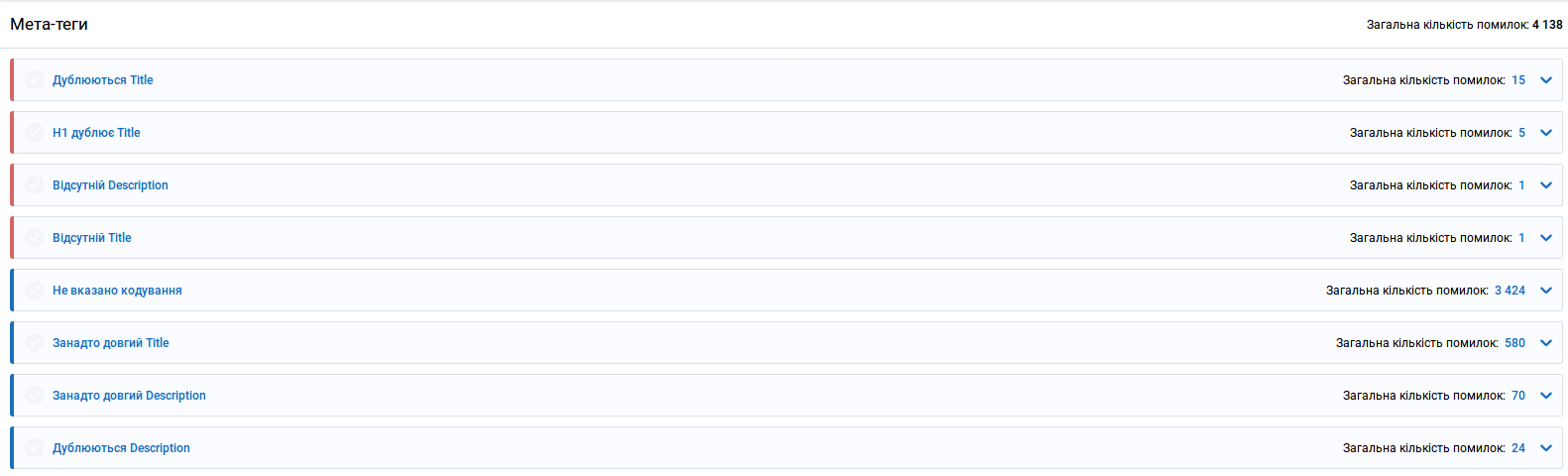

- Всі сторінки сайту повинні мати свій унікальний Title і Description, які точно описують їх зміст. Це стосується і сторінок пагінації (2 ст, 3 ст і т. д.).

Перевірити унікальність цих тегів можна за допомогою спеціалізованих сервісів або програм: Serpstat, Netpeak Spider, WebSite Auditor та ін.

- ЛЗУ (людизрозумілі урли) для всіх просуваних сторінок, а ще краще для всіх сторінок сайту.

Наприклад, https://site.ua/product/choboti-lemigo-vermont-877-eva-7/ а не https://site.ua/product/0789ofd

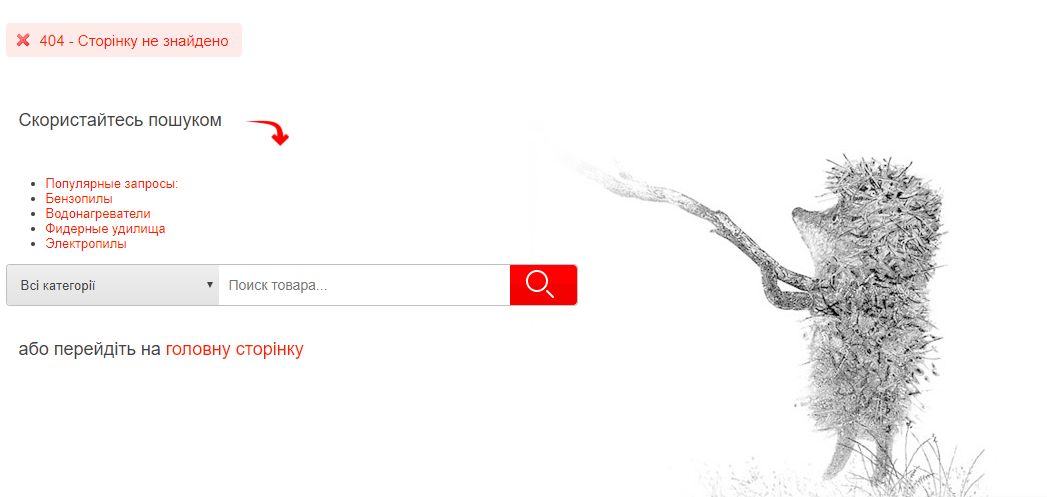

- Наявність і коректність роботи сторінки з помилкою 404. Сторінка повинна віддавати відповідь з кодом «404 Not Found».

Сторінка з помилкою 404 повинна виводитись при введенні помилкових URL-адрес. Дизайн цієї сторінки повинен бути в стилі сайту і містити посилання на основні сторінки сайту, а також форму пошуку.

- Всі сторінки, доступні за посиланнями, повинні мати код відповіді «200 ОК».

Потрібно просканувати сайт спеціальними сервісами або програмами: Netpeak Spider, ScreamingFrog, WebSiteAuditor та ін.

Якщо є сторінки з 301 перенаправленням ― потрібно скорегувати URL внутрішніх сторінок на сайті. Вони повинні відразу вести на кінцеву мету.

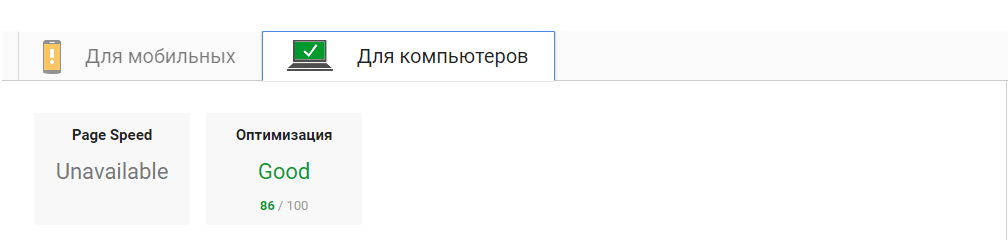

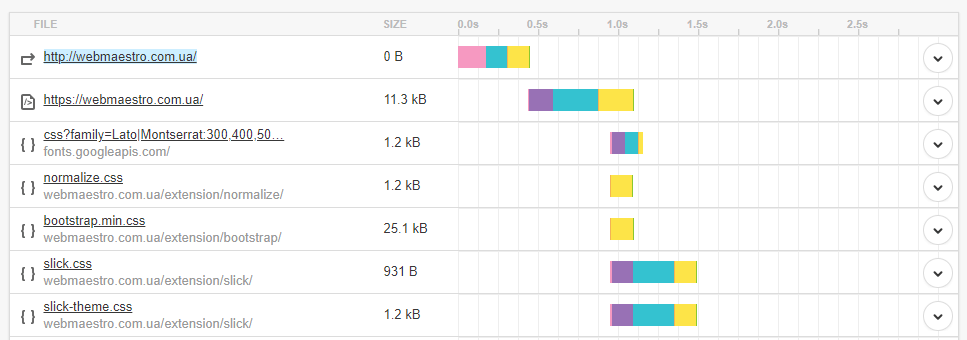

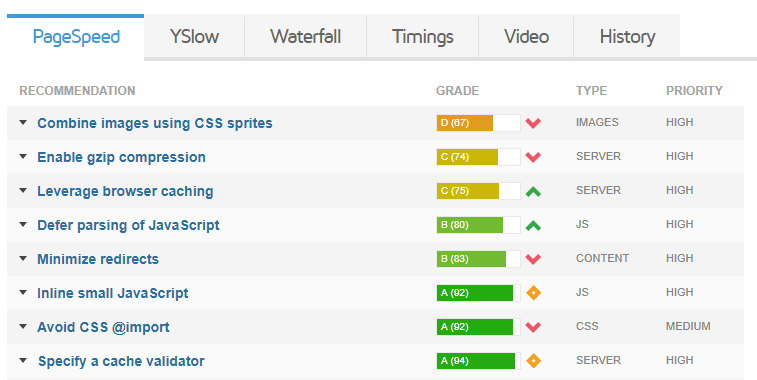

- Час завантаження сторінок сайту і їх розмір в КБ.

Рекомендовані показники:

- час завантаженняи вихідного коду документа ― до 0,7 с (700 мс);

- час відповіді сервера ― до 0,2 с (200 мс);

- розмір вихідного коду ― до 120 Кб.

Можете скористатися наступними сервісами:

- Google Page Speed Insights https://developers.google.com/speed/pagespeed/insights:

- Pingdom Tools https://tools.pingdom.com/

- Gtmetrix https://gtmetrix.com/

- PR-CY https://pr-cy.ru/speed_test/

- На всіх сторінках обов'язково повинен бути заголовок в тезі Н1 і він повинен бути тільки один.

Заголовок в тезі Н1 повинен точно описувати вміст сторінки і відрізняться від Title.

- Перевірте, щоб теги Н1..Н6 використовувалися за призначенням, а не як елементи оформлення сайту.

Неправильно:

<Н1>Наш номер телефону: 066-123-45-67Правильно:

<Н1>Розробка сайтів - Аптайм сервера повинен мати показник 99,85% і вище.

Для перевірки можете скористатися онлайн-сервісом https://www.host-tracker.com.

- Привабливий і оригінальний favicon.ico, який повинен знаходитися в корені сайту.

- За допомогою AJAX приховати посилання на сторінках, закритих від індексації в robots.txt, щоб статична вага всередині сайту розподілялася правильно. У вихідному коді сторінок сайту не повинно бути конструкції типу «a href =" ... "» з посиланнями на такі сторінки.

Скрипт також потрібно буде закрити від індексації.

- Великі фрагменти JS і CSS (8-10 рядків і більше) винести в окремі файли певного типу, які підключаються окремо. Всі тимчасові коментарі (більше 3-5 рядків) видалити. Це прискорить завантаження та інтерпретацію коду пошуковими системами і браузерами.

- Перевірте валідність коду на наявність незакритих парних тегів.

Це можна зробити за допомогою онлайн-валідатора W3C Markup Validator Service https://validator.w3.org.

- Перевірте коректність відображення сайту в найпопулярніших браузерах (кросбраузерність): Google Chrome, Opera, Mozilla Firefox, Android Browser, Safari Mobile.

- Всі URL сторінок сайту повинні мати однакову конструкцію (або зі слешем вкінці «/» або без нього, чи з суфіксом .php, .html).

Наприклад, site.ua/development/

site.ua/development

site.ua/development.php

- Правильно налаштуйте 301-редірект з версії сайту http на версію https для уникнення дублювання контенту.

- Закрийте від індексації у файлі robots.txt сторінки пошуку, фільтрації, сортування (якщо вони не оптимізовані для просування по НЧ-запитах), сторінку з помилкою 404, сторінки входу в адмін-панель, сторінки авторизації, зміни пароля, оформлення замовлення, версії для друку, сторінки вчинення дії, розділи з дубльованим контентом (наприклад, RSS-фіди) за допомогою директиви Disallow:

Також приховайте від індексації файли з розширенням *.doc, *.pdf, якщо вони не несуть корисної інформації. - Як альтернативу файлу robots.txt можна використовувати тег name = "robots" зі значенням «content ="noindex, follow"».

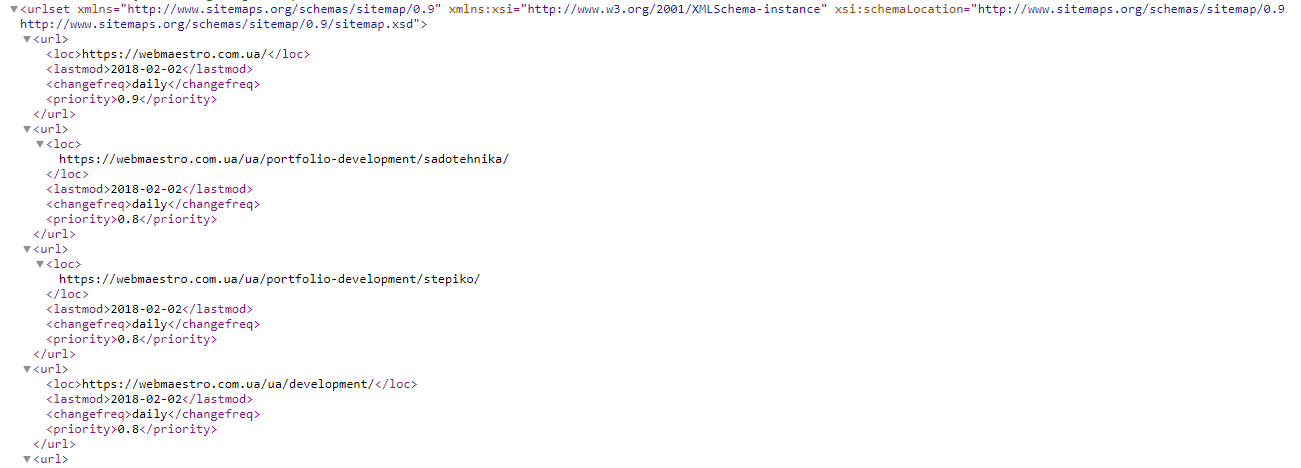

- Сформуйте карту сайту sitemap.xml, де перерахуйте всі сторінки сайту.

Потім перевірте карту сайту на валідність за допомогою опції Перевірка файлу Sitemap в Google Search Console https://www.google.com/webmasters/tools/sitemap-list.

Якщо число сторінок сайту перевищує 50 тис., потрібно створити кілька карт. - Якщо на сайті є посилання на сторонні сайти, прописуємо їм відкриття в новій вкладці за допомогою target = "_ blank" і приховуємо їх від пошукових систем за допомогою AJAX.

- Налаштуйте rel = "canonical" щоб виключити дублі сторінок.

Правильно налаштований атрибут rel = "canonical" для тегу link:

- спростить настройку індексації сайту;

- допоможе правильно враховувати і склеювати статистику на дубльованих сторінках.

- Навіть якщо Ви правильно і детально налаштували індексацію, необхідно постійно переглядати попадання дублів контенту в індекс ПС. Це робиться за допомогою операторів цитатного пошуку та оператора «site:».

Висновок

Такі помилки, як дублі сторінок в пошуку або випадання важливих сторінок з пошуку, можуть стати перешкодою на шляху до ТОПу пошукової видачі.

У цій статті ми описали найкорисніші роботи з технічної оптимізації сайту. Ви можете їх використовувати як чек-лист у своїй роботі.

Пам'ятайте, коректна технічна оптимізація сайту ― фундамент розкрутки!

Ви можете звернутися до нас і всі ці роботи ми проведемо на Вашому сайті самі. Звертайтеся!

![SEO БОМБА від WEBMAESTRO [Мультиканальна розкрутка], блог, фото](/img/blog/20180324192737_.jpg)

Бажаєте встановити наш додаток?

Бажаєте встановити наш додаток?

відповісти

відповісти

відповісти

відповісти

відповісти