FAQ robots.txt: запитання й відповіді

- Robots.txt - що це?

- Потрібен чи ні robots.txt?

- Де знаходиться файл robots.txt?

- Як виглядає стандартний robots.txt?

- Що повинно бути в robots.txt?

- Як виглядає robots.txt для Гугла і Яндекса?

- Як вказати головне дзеркало в robots.txt?

- Як прописати карту сайту в robots.txt?

- Що означають символи в robots.txt?

- Як налаштувати robots.txt?

- Як перевірити robots.txt?

- Помилки в robots.txt

Robots.txt - що це?

Файл robots.txt - це індексний файл у текстовому форматі, який рекомендує пошуковим роботам (наприклад, Google, Yandex) які сторінки сканувати, а які ні.

Потрібен чи ні robots.txt?

Однозначно так. Він допомагає пошуковим роботам швидше розібратися, які сторінки потрібно індексувати, а які ні.

Де знаходиться файл robots.txt?

Файл розташовується в кореневій папці сайту і доступний для перегляду за адресою: https://site.ua/robots.txt

Як виглядає стандартний robots.txt?

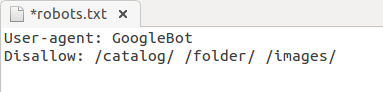

Robots.txt приклад:

Що повинно бути в robots.txt?

Атрибути robots.txt:

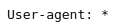

- User-agent - описує яким саме роботам потрібно дивитись інструкцію. Існує близько 300 пошукових роботів (Googlebot, Yandexbot і т.д.). Щоб вказати інструкції відразу для всіх роботів слід прописати:

Інші роботи:- Ahrefsbot;

- Exabot;

- SemrushBot;

- Baiduspider;

- Mail.RU_Bot.

- Disallow - вказує роботу, що не потрібно сканувати.

Відкрити для сканування весь сайт (robots.txt дозволити все):.png)

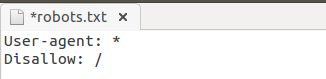

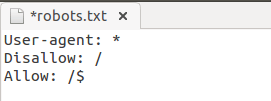

Заборонити сканування всього сайту (robots.txt заборонити все):

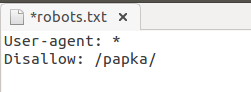

robots.txt заборонити індексацію папки:

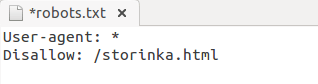

Заборонити індексацію сторінки в robots.txt:

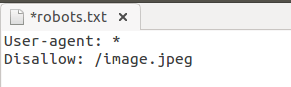

Заборонити індексацію конкретного файлу:

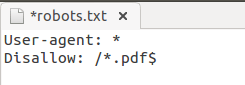

Заборона індексації всіх файлів на сайті з розширенням .pdf:

Заборонити індексацію піддомену в robots.txt:

Кожен піддомен має свій файл robots.txt. Якщо його немає — створіть і додайте в кореневу папку піддомена.

Закрити всі крім головної в robots.txt:

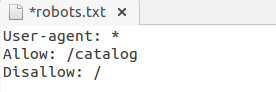

- Allow - дозволяє роботу сканувати сайт/папку/конкретну сторінку.

Наприклад, щоб дозволити роботу сканувати сторінки каталогу, а все інше закрити:

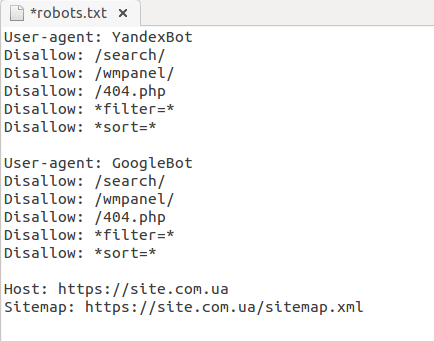

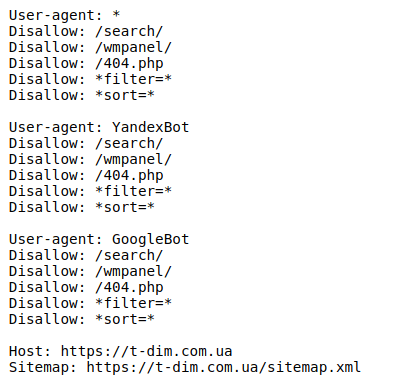

Як виглядає robots.txt для Гугла і Яндекса?

Як вказати головне дзеркало в robots.txt?

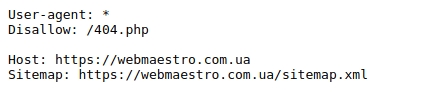

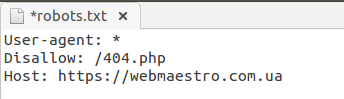

Для позначення головного дзеркала (копії сайту, доступною за різними адресами) використовують атрибут Host.

Host в robots.txt:

Як прописати карту сайту в robots.txt?

Карта сайту (sitemap.xml) повідомляє пошуковим роботам пріоритетні сторінки для індексації. Вона знаходиться за адресою: https://site.com/sitemap.xml.

Sitemap в robots.txt:.png)

Що означають символи в robots.txt?

Найбільш часто використовуються наступні символи:

- "/" - закриття від робота всього сайту/папки/сторінки;

- "*" - будь-яка послідовність символів;

- "$" - обмеження дії знака "*";

- "#" - коментарі, які не враховуються роботами.

Як налаштувати robots.txt?

У файлі обов'язково потрібно окремо для кожного робота прописати, що відкрито для сканування і що закрито, прописати хост і карту сайту.

Файли robots.txt розрізняються між собою залежно від використовуваної CMS.

Рекомендуємо закривати від індексації сторінки: авторизації, фільтрації, пошуку, сторінку 404, вхід в адмінку.

Приклад ідеального robots.txt:

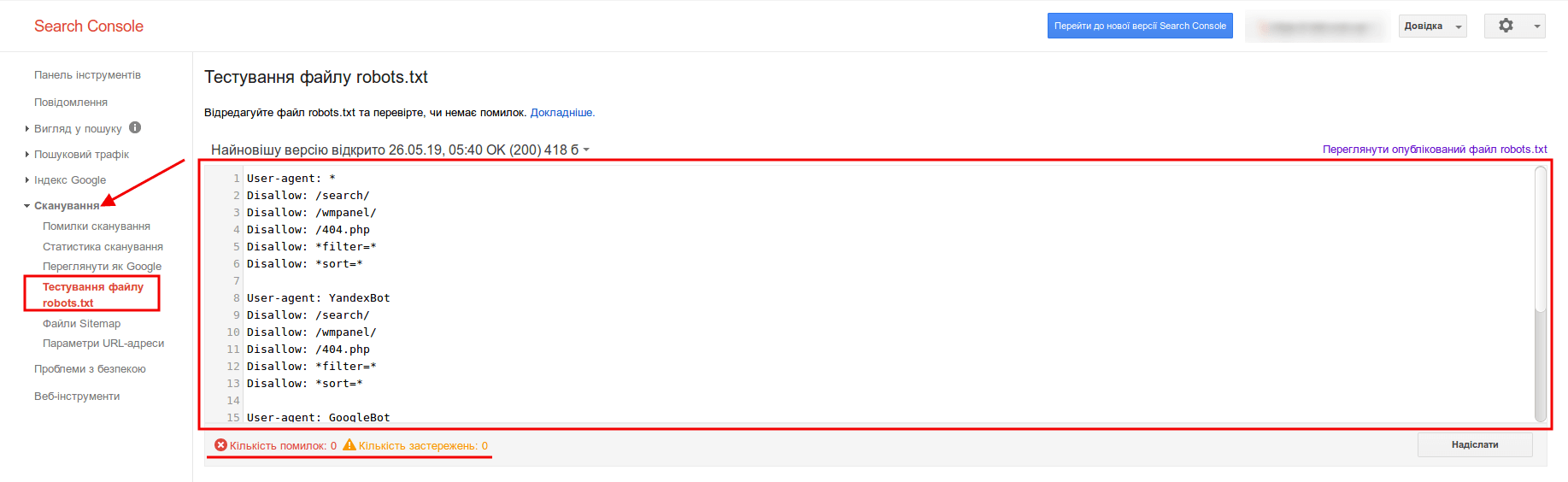

Як перевірити robots.txt?

Щоб перевірити валідність robots.txt (чи правильно заповнений файл) - використовуйте інструмент для веб-майстрів Google Search Console. Для цього достатньо ввести код файлу в форму, вказати сайт і Ви отримаєте звіт про коректність файлу:

Помилки в robots.txt

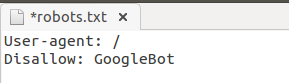

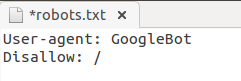

- Переплутали місцями інструкції.

Неправильно:

Правильно:

- Записали декілька папок одразу в одній інструкції:

- Не правильна назва файлу — не Robot.txt і не ROBOTS.TXT, а robots.txt!

- Правило User-agent не повинно бути порожнім, обов'язково потрібно вказувати для яких роботів воно діє.

- Слідкуйте, щоб не було зайвих символів у файлі ("/", "*", "$" і т.д.).

- Не відкривайте для сканування сторінки, які не потрібні в індексі.

Підійдіть з усією відповідальністю до формування файлу robots.txt - і буде Вам щастя;)

![SEO БОМБА від WEBMAESTRO [Мультиканальна розкрутка], блог, фото](/img/blog/20180324192737_.jpg)

Бажаєте встановити наш додаток?

Бажаєте встановити наш додаток?