Еволюція алгоритмів ранжування Google

У цій статті ми розповімо про те:

- яким пошуковик Google був раніше;

- які методи фільтрації результатів видачі він використовував;

- коли та які оновлення впроваджував;

- як сьогодні він ранжує сайти.

З чого все починалося?

Перше що спростив Інтернет ― це спілкування між людьми і компаніями завдяки електронній пошті. Потім з'явилася необхідність зробити інформацію загальнодоступною.

Спрощення процесу пошуку і його загальнодоступність стали основною концепцією роботи Google, Yahoo та ін. Коли Інтернет дійшов до Росії, в конкуренцію включилися Rambler, Яндекс, LiveInternet.

Періоди розвитку Google

- Недостатня кількість контенту

Коли контенту в Інтернеті було мало, власники сайтів думали тільки про одне ― щоб їхній сайт знайшли.

У той період жоден пошуковик не міг забезпечити точну відповідність запиту на першій сторінці видачі, і користувачі мусили переглядати всі результати видачі. А все тому, що:

- Інформації було дуже мало.

- Контент взагалі не був оптимізованим.

- Алгоритми ранжування були занадто примітивними.

Наприклад, щоб сайт показувався в пошуковій видачі досить було прописати мета-теги на сторінці:

- заголовок (Title) ― щоб сайт видавався за певним запитом, досить було прописати його в заголовку сторінки і в мета-тегу Keywords;

- короткий опис (Description) ― якщо пошукова система не знаходила запит в ключових словах і заголовках, вона шукала в описі;

- ключові слова (Keywords) ― прописували багато ключових слів, щоб пошуковик знайшов сторінку сайту.

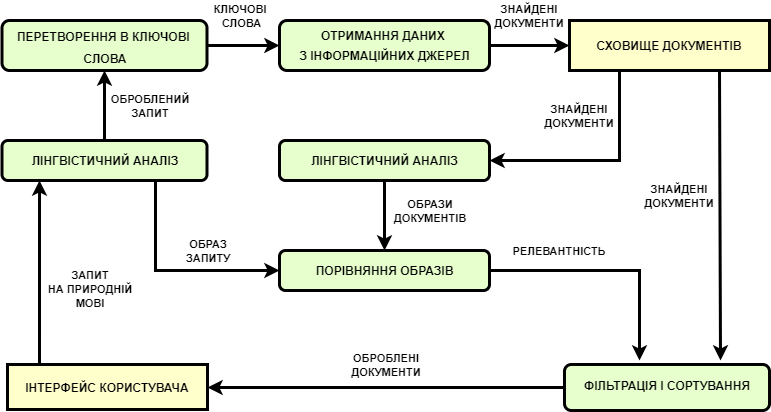

Пошукові системи працювали за таким алгоритмом:

Головною метою Google було знайти що-небудь максимально схоже на запит користувача.

У той час всі пошуковики конкурували між собою, і той, який умів знаходити найбільш релевантні результати ― займав місце монополіста. Наприклад, перші пошукові системи з'явилися в 1993-1995 роках (Aliweb, Lycos, WebCrawler і ін.), Google був створений в 1998 році, Яндекс ― в 1997, Rambler ― 1996 року, Yahoo ― 2004, Bing ― 2004-2005 рр.

- Зростання кількості контенту

Коли почало з'являтися більше контенту в мережі, в пошуковій видачі стало мало місця і всі хотіли потрапити на першу сторінку видачі. У той період в лідери вибилися 2 пошуковики: Google та Яндекс. Всі почали освоювати найпростіші алгоритми ранжування. Саме тоді і виникла спеціальність SEO-оптимізатор.

Всі сайти стали оптимізовувати за декількома принципами:

- Максимальний переспам ключовими словами в контенті та в мета-тегах.

- Нарощування маси спамних посилань, «надування» SEO-показників сайту (трасту, трафіку, PageRank, ТІЦ та ін.).

Тоді і зародилося «чорне» SEO ― створювалося багато спамних сторінок під певні ключові запити, які переправляли на інші сайти. Пошукова видача сильно зіпсувалася. Зараз використання такої схеми загрожує потраплянню під санкції та зникненню з пошукової видачі.

- Поява апдейтів (оновлень)

У цей період зріс ризик «підчепити» вірус з пошуку або потрапити на спамний сайт, дорвей або фішинг-сайт. Він почався у 2005 році та триває по сьогодні. У цьому періоді можна виділити 2 етапи:

- Становлення алгоритмів ранжування (2005-2011 рр.). На цьому етапі створювалися перші алгоритми фільтрації пошукової видачі і саме тоді зародилися чорні методи SEO.

- Вагомі апдейти пошукових систем спрямовані на боротьбу з нечесними методами оптимізації сайтів (2012-2017 рр.).

Другий етап розвитку пошукових систем є природним процесом еволюції: атака («чорних» оптимізаторів) і захист (пошукових систем).

Саме в цей період найбільші пошукові системи, такі як Яндекс і Google, почали ретельно боротися за кожного користувача і впроваджувати перші алгоритми ранжування. Чорним SEO-шникам довелося йти з професії або вдаватися до інших способів розкрутки сайтів.

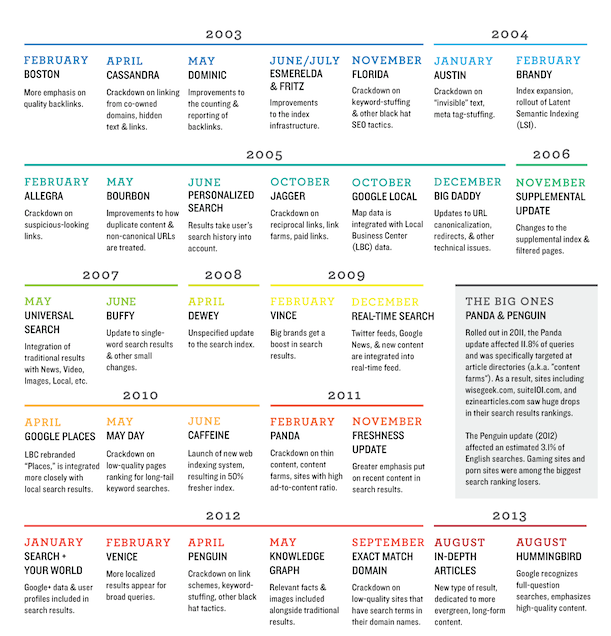

Найважливіші апдейти Google

- Boston (лютий 2003 рік) ― перший офіційний апдейт Google. Використовувалися різні способи зміни алгоритмів, чіткої спрямованості не було.

- Cassandra (квітень 2003) ― пошукова система відсівала сайти з прихованими посиланнями і текстами, посиланнями з сайтів-дорвеїв, які належали одному власнику.

- Dominic (травень 2003) ― Google став по-іншому враховувати зворотні посилання, з'явилися боти Deepcrawler і Freshbot.

- Esmeralda (червень 2003) ― останній етап апдейта Boston.

- Fritz (липень 2003) ― після нього оновлення стали відбуватися щодня, а не щомісяця.

- Florida (листопад 2003) ― видаляє з видачі сайти перенасичені ключовими словами, неунікальним контентом, купленими посиланнями.

- Brandy (лютий 2004) ― Google починає розуміти LSI-запити, анкори посилань.

- Nofollow (січень 2005) ― Google впроваджує параметр nofollow для боротьби зі спамними посиланнями.

- Bourbon (травень 2005) ― виділив сайти з www та без www як дубльований контент.

- Персоналізований пошук (червень 2005) ― Google почав використовувати файли cookies для формування пошукової видачі згідно з персональними вподобаннями.

- XML-карта сайту (червень 2005) ― Google ввів поняття карти сайту sitemap.xml і став використовувати її для поліпшення індексації.

- Jagger (жовтень 2005) ― відсіювання сайтів створених для покупки та обміну посиланнями.

- Big Daddy (грудень 2005) – ввелись нові поняття: канонізація, редіректи та ін.

- Універсальний пошук (травень 2007) ― у видачі з'явилися картинки, новини, відео, локальні сайти.

- Suggest (2008) ― з'явилися пошукові підказки.

- Rel-canonical (лютий 2009) ― Google та інші пошукові системи дозволили веб-майстрам налаштовувати канонічні сторінки.

- Caffeine (серпень 2009) ― почалися вводитися новинки: видача в реальному часі, швидкість сканування та індексації, розширений індекс. Великого значення набув контент, частота оновлення сайту, внутрішня оптимізація, швидкість завантаження сторінок. Впроваджуються санкції за спамність та технічні проблеми на сайті.

- Пошук в реальному часі (грудень 2009) ― зростає швидкість індексації сторінок.

- May Day (травень 2010) ― стали враховуватися низькочастотні запити з довгим «хвостом».

- Миттєвий пошук (вересень 2010) ― результати видачі стали надаватися в момент набору запиту користувачем.

- Негативні відгуки (грудень 2010) ― пошукова система почала враховувати при ранжуванні сайтів відгуки користувачів.

Потім оновлення почастішали.

Найвідоміші апдейти Google

- Panda (лютий 2011) ― апдейт знизив позиції сайтів зі слабким контентом і «ферми» контенту переспамлені низькочастотними запитами. Алгоритм удосконалювався до 2015 року.

- PayDay Loan (2013-2014) ― відсіював спамні фінансові та порно-сайти.

- Penguin (квітень 2012) ― аналізував кількість та якість зовнішніх посилань на сайт і фільтрував спам, а також моніторив зовнішні та внутрішні показники. Тоді і був впроваджений інструмент Disavow Links для відхилення сумнівних зовнішніх посилань.

- Pigeon (липень 2014 року) ― коригування локального пошуку, для деяких запитів враховувалась відстань від користувача до адреси компанії.

- Pirate (серпень 2012) ― введені правила DMCA для боротьби з піратським контентом, який видалявся з пошукової видачі.

- EMD (вересень 2012) ― назва домену перестала враховуватися при ранжуванні.

- Top heavy (січень 2012) ― з видачі виключені сайти переспамлені рекламою (банерами і відео).

- Hummingbird (серпень 2013) ― введена кластеризація ключових слів за темами, що дало можливість Google видавати більш релевантні результати.

- Mobile Friendly (2015) ― в пошуковій видачі віддавалася перевага сайтам з мобільного адаптацією.

Таким чином, ми бачимо, що Google еволюціонував в бік спрощення процесу пошуку та максимального задоволення потреб користувачів.

Як Google ранжує сайти?

Пошукові системи працюють за схемою: обробити введений пошуковий запит та представити правильні відповіді.

Всі пошукові системи ґрунтуються на 3 правилах:

- Актуальність

Інформація на сайті завжди повинна бути актуальною. Наприклад: ціни товарів, їх опис, фотографії, наявність на складі, актуальна інформація в блозі.

- Повнота

Детальна інформація про товари/послуги. Поділ контенту по сторінках, його структурування.

- Популярність

Просувайте контент, посилайтеся на нього з інших джерел: соціальних мереж, новинних порталів, ЗМІ і т. д.

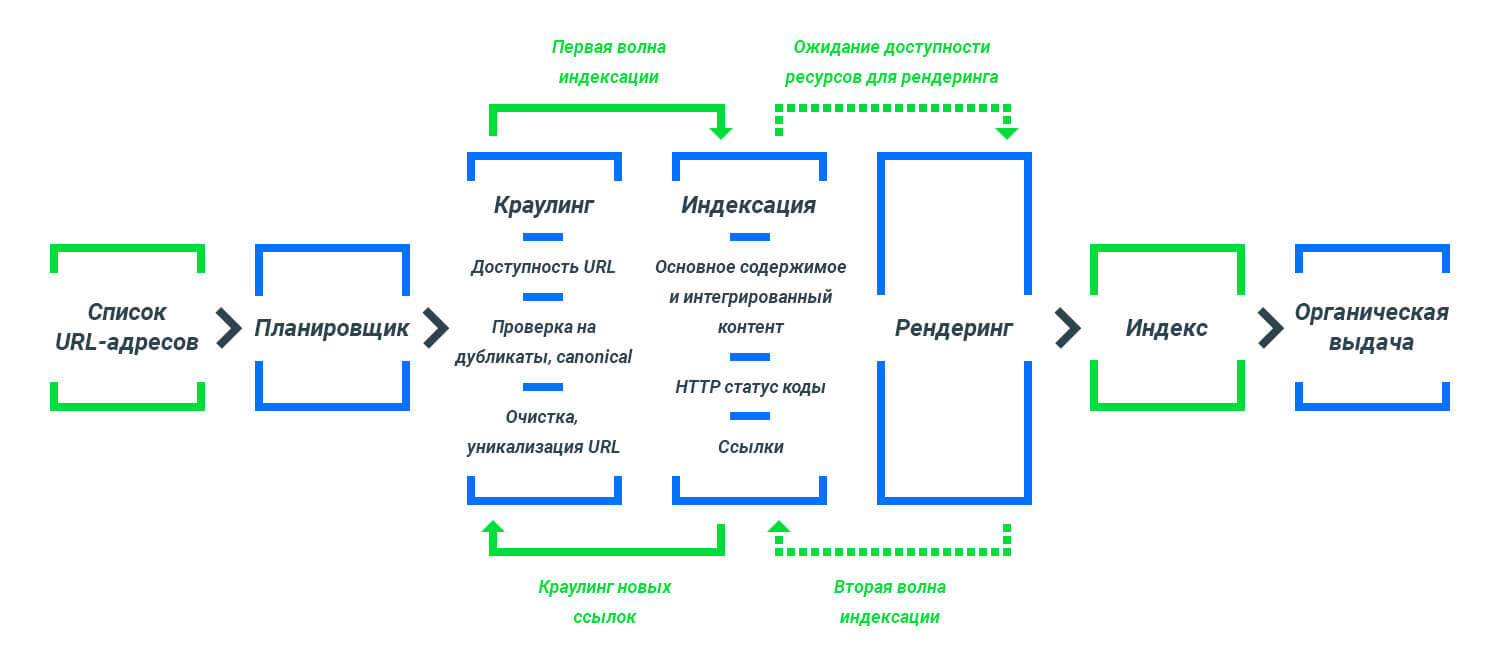

Процес потрапляння сторінок сайту в пошукову видачу Google

Фактори ранжування в Google 2019

Google має безліч факторів ранжування. Найбільш пріоритетні з них:

- Кількість прямих переходів на сайт.

- Час, який користувачі проводять на сайті, кількість переглянутих сторінок, відсоток відмов.

- Кількість доменів, які посилаються.

- Довжина контенту.

- Наявність протоколу безпеки HTTPS.

- Кількість анкорів, ключових слів в анкорах.

- Наявність ключових запитів на сторінці.

- Щільність ключових запитів.

- Наявність ключових слів в заголовках (H1, H2 ...).

- Наявність ключових слів в мета-тегах (Title, Description).

- Наявність відео на сторінці.

- Вік домену.

- Технічна складова сайту (мінімум редіректів, правильне налаштування сторінки 404, висока швидкість завантаження сайту, наявність мобільної адаптації, мікророзмітки і т. д.).

Тепер Ви знаєте пріоритети пошукової системи Google.

Висновок

Отже, ми бачимо, що на сьогоднішній час Google досяг дивовижного рівня розвитку і навчився точно розуміти запити користувачів, та при ранжуванні видає максимально релевантні результати.

За якісною розкруткою сайту звертайтеся до нас ― ми розробимо стратегію розвитку Вашого сайту відповідно до рекомендацій Google!

Бажаєте встановити наш додаток?

Бажаєте встановити наш додаток?